AIガバナンスへの取り組みでは、一定の企業で関連法令や各種ガイドラインの調査、規定類の策定が進む一方、実際に活動を進める中で様々な課題が顕在化することがあります。本記事では、これらの課題に対応するためのポイントや、AIガバナンス構築推進のヒントを提供します。

1.AIガバナンスの重要性

現代のビジネス環境において、AIの活用は企業にとって競争優位性を左右する重要な要素となっています。しかし同時に、企業が直面したことのない新たなリスクも生み出しています。実際に、以下のようなインシデントが発生しています。

- 学習データにおける偏見により、AIが差別的発言を行いサービス停止に追い込まれた

- AIの不適切な応答により、相談者の精神状態が悪化し自殺に至った

- AIが割引サービスに関する誤情報を提供し、利用者の経済的損失から賠償問題に発展した

AIを活用する企業は、こうしたインシデントを未然に防ぎ、AIリスクに適切に対処することが求められています。また、AIに関連するリスクの領域は従来のITリスクより拡大しています。情報漏えいやシステム・データ破壊、不正確な情報や偽情報の拡散、倫理・コンプライアンス違反、各種権利侵害、各国の法令や規約違反、説明責任の不足など、多岐にわたります。

このような背景を踏まえ、AIの活用やAIシステム・サービスの開発・提供に伴うAIリスクに適切に対処するために、「AIガバナンス」の構築が不可欠です。加えて、AIガバナンスへの取り組みの意義は、単なるリスク管理にとどまらず、AIの活用や開発・提供において信頼性や透明性、倫理性を確保することで、顧客や社会、ステークホルダーからの信頼を獲得し、企業や組織の社会的責任を果たすことにもつながります。さらに、ガバナンス体制のもとで継続的な改善を重ねることにより、AIの品質や有用性を高め、変化の激しい市場環境においても競争力を維持・強化することが可能となります。

本記事では、AIガバナンスを「企業・組織がAI技術に関わるリスクに適切に対処し、未然にリスクを防ぐこと、そしてAI技術を安全かつ責任を持って活用、開発・提供するために必要な方針・ルール・体制・プロセスを整備・運用する枠組み」と定義します。そして、AIガバナンス構築にあたって企業が直面する課題と、その効果的な対処法について詳しく解説します。

2.企業のAIガバナンス構築推進に関する現状と課題

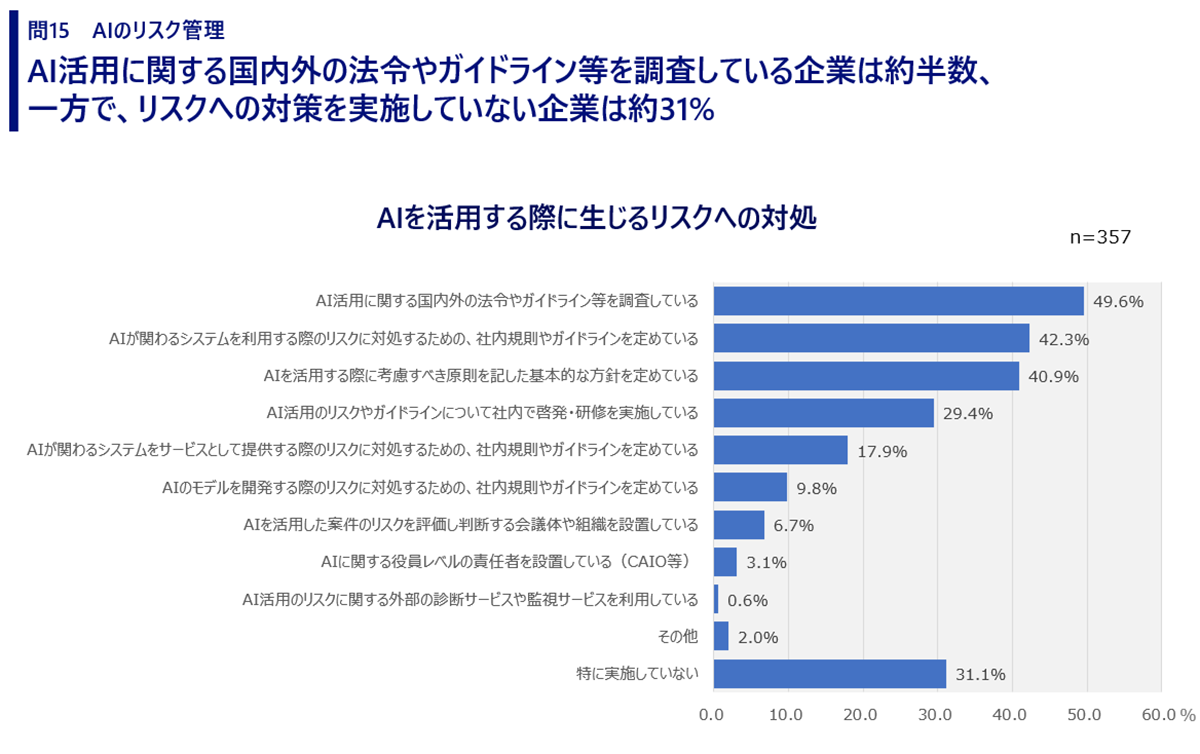

NRIの「ユーザ企業におけるIT活用実態調査」(2024年9月)によると、7割近くの企業がAI活用に伴うリスクに対して何らかの対策を行っていることが明らかになりました。対策として、国内外の関連法令やガイドラインの調査を行っている企業が49.6%で最も多く、社内規則やガイドラインの策定(42.3%)、基本的な方針の策定(40.9%)が続いています。

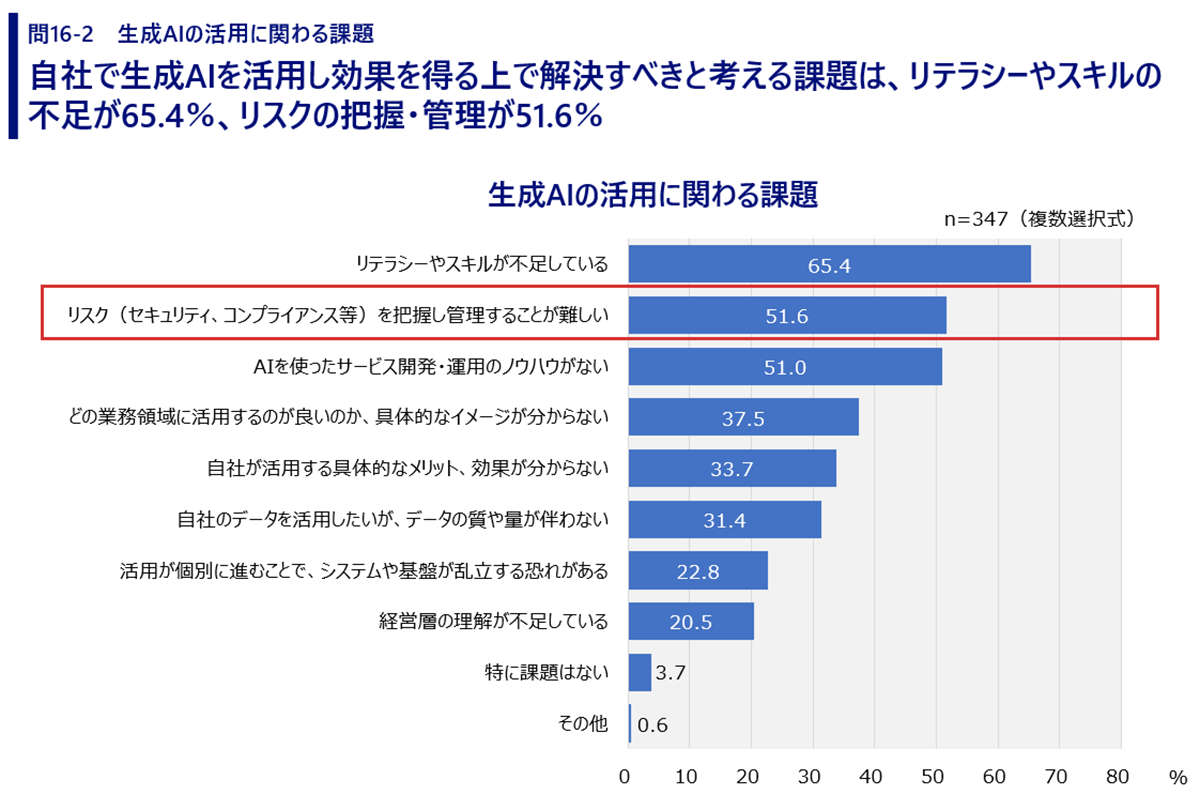

同調査によると、近年、企業における利用が急速に拡大している生成AIについては、リスクの把握・管理が難しいと感じている企業が51.6%に上ることが明らかになっています。生成AIは、AIの利用に詳しくない一般社員も利用するため、リスクの把握・管理が行き届いていない現状が浮かび上がりました。このような課題を感じている企業にとっては、適切なAIガバナンスを構築することで、課題を解決し、不安を払拭することが不可欠だと言えます。

AIリスクに対して約7割の企業が何らかの対策を行っており、AIガバナンス構築の取り組みは着実に進んでいるにもかかわらず、いまだ51.6%の企業がAIリスクに対して課題を感じています。すなわち、多くの企業がAIリスクへの対処が十分ではないと認識していると考えられます。したがって、企業がAI活用の効果を最大限に享受するためには、AIガバナンスの取り組みを推進し、その実効性をさらに高めていくことが不可欠です。

しかし、AIガバナンスの取り組みを進めているものの、その過程でさまざまな課題に直面し、思うように進められない企業を多く見てきました。次の章では、直面しやすい課題を具体的に挙げ、それらへの対策について詳しく解説します。

3.AIガバナンス構築推進における課題と実践的な対策

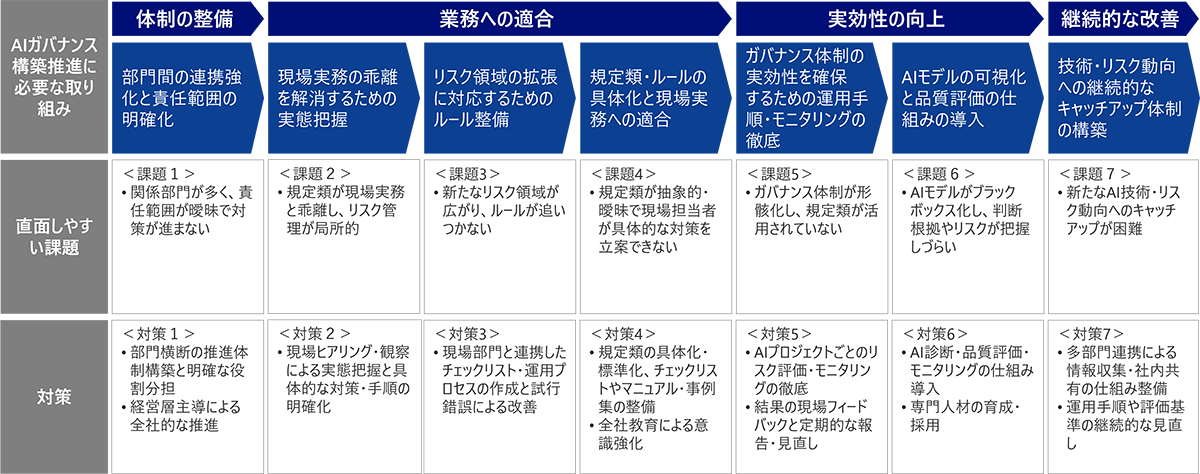

AIガバナンス構築を進めるうえで必要な取り組みは7つに整理できます。本章では、これらの取り組みに関連して、AIガバナンスを推進する際に直面しやすい課題と、その対策を詳しく解説します。

部門間の連携強化と責任範囲の明確化

<課題1>

AIの活用と開発・提供においては、IT・デジタル部門、現場部門、法務部門、広報部門、リスク管理部門など多くの組織や担当者が関わります。これは、AIが技術的な側面だけでなく、業務運用、法的遵守、リスク管理、倫理・社会的責任など、幅広い観点から検討や対応が求められるためです。そのため、関係者が多くなる一方で、責任範囲がはっきりせず対策が進まないケースがあります。

<対策1>

まず、部門横断の推進体制の構築と明確な役割分担が欠かせません。

AI活用においては、技術的なリスクだけでなく、倫理的・社会的なリスクが絡むため、IT・デジタル部門や現場部門だけでなく、法務部門、広報部門、リスク管理部門など多様な専門性を持つ部門が連携する必要があります。そのため、AI活用に関わる関係者が連携できるよう、部門横断のプロジェクトチームや委員会の設置や、各部門の責任範囲や担当者の明確化を行います。プロジェクトの企画段階から各部門代表と経営層が参画し、リスク・対応策を初期から合意形成することで、部門ごとの役割、意思決定権限、責任者を明確に定義します。

また、全社横断的なワークフローや推進体制を整えることで、「誰が・どの観点を・どの段階で確認・合意するか」を明確にし、対策の停滞や責任の曖昧さを防ぎます。さらに、経営層が主導してAIガバナンス構築推進の重要性を発信し、経営層自身が方針決定やリソース配分に積極的に関わることで、全社的な取り組みとしての推進力を高めていきます。経営層が定期的にAIリスクマネジメントの重要性や、各部門の期待役割について発信することも重要です。

現場実務の乖離を解消するための実態把握

<課題2>

企業において、規定類・ルールを作成したものの、それらの内容と現場実務が乖離しているため、リスク管理が局所的な活動にとどまっているケースが見られます。

例えば、AI開発担当者が「データバイアスを防ぐ」とだけ書かれたルールを見ても、どのようなテスト手法や評価指標を用いればよいかが不明確で、実際のデータ収集やモデル検証に反映されていないことがあります。

結果として、現場のAI開発担当者は最低限の作業しか行わず、リスク管理が特定の工程や個人の判断に委ねられてしまい、組織的なガバナンスが確立されない状況に陥ります。

<対策2>

この問題を解決するには、現場実務とAIの活用パターンを把握した上で、具体的な対策内容と手順を明確化することが重要です。

具体的には、各業務部門やAI活用現場へのヒアリングや現場観察を通じて、AIの実際の使われ方、運用パターン、潜在リスクを詳しく把握し、それに基づいたリスクシナリオや対策パターンを整理することが必要です。

リスク領域の拡張に対応するためのルール整備

<課題3>

生成AIには、従来リスク(情報漏えいなど)の拡張に加え、新たなリスク(不正確な情報や偽情報、倫理・コンプライアンス違反、各種権利侵害など)が潜んでいるため、対処すべき領域が広く、ルールが追いつかず具体化が困難となるケースがあります。

<対策3>

対策として、AIガバナンス推進部門による、現場部門や関係部門と連携した規定類・ルールやチェックリスト、運用プロセスに関する試行錯誤が求められます。

まず、規定の整備だけでなく、現場実務に沿ったリスク確認項目とその対策に関するチェックリストや運用プロセスを作成することが大事です。そして、現場部門や関係部門と密接に連携して試行錯誤を通じて改善することとアジャイルガバナンスが不可欠となります。

具体的には、開発・運用担当者が確認すべきリスクとそれに対する対策を確認・実施するためのチェックリストを作成するとともに、その運用プロセスを整備します。また、バイアス検証やデータ品質チェックなど、開発工程や運用プロセスに具体的なタスクとして組み込むことも重要です。さらに、開発・運用担当者や関係部門がアジャイルに試行錯誤できる小規模パイロットの場を用意し、改善点を素早く規定や運用ルールへ反映していくことで、実効性のあるガバナンス体制を構築できます。

規定類・ルールの具体化と現場実務への適合

<課題4>

規定類・ルールの抽象度が高すぎる・曖昧すぎるため、現場担当者が何をどのように対策すればよいか分かりにくいケースがあります。

例えば、「AIによる意思決定の透明性を確保する」とだけ記載されていても、何をもって透明性とするのか、どのような説明やログ取得が必要なのか具体的な指針が示されていません。結果として、現場担当者が具体的な対策を立案できず、判断に迷い、対応が先送りになってしまいます。

<対策4>

対策として、規定類・ルールの具体化と現場実務への落とし込みが不可欠です。

規定類・ルールの抽象的・曖昧な表現については、開発・運用担当者が具体的に「何を」「どのように」実施すればよいかを明確に示すよう、個別の対策事項を分かりやすく細分化したチェックリストの作成が必要です。あわせて、実際の業務フローに即したマニュアルや事例集を整備し、担当者が迷わず正しく運用できるよう規定類・ルールを具体化・標準化することが重要です。

また、教育等を通じて、組織全体の意識を強化を行っていくことが大切です。経営層から現場担当者まで、AIリスクに対する認識を共有し、ガバナンスが形骸化しない文化づくりが重要となります。

具体的には、経営層がAIリスク管理の重要性を定期的に発信し、各部門がリソース確保や規定類・ルール、運用プロセスの改善に集中できるよう後押しすることが求められます。さらに、勉強会や社内イベントでAIのリスクとガバナンスの事例を紹介し、担当者の意識とスキルをアップデートする全社教育・継続的な情報発信も欠かせません。

ガバナンス体制の実効性を確保するための運用手順・モニタリングの徹底

<課題5>

ガバナンス体制が形だけで運用の仕組みがないために、整備した規定類・ルールが活用されていないケースが見受けられます。

例えば、AI倫理委員会やガバナンス推進部署が設置されていても、会議は形式的に行われているだけで、実際にAIプロジェクトのリスク評価やモニタリングを行う仕組みが作られていません。結果として、表面的にはルールがあるという状態になり、リスクを未然に防ぐ構造となっていない状況が生まれています。

<対策5>

対策として、ガバナンス体制の実効性を担保するための運用手順とモニタリングを徹底しましょう。

AIガバナンス推進部門がAIプロジェクトごとにリスク評価・モニタリングを必ず実施し、その結果を現場へフィードバックする仕組みを運用手順として定着させることが重要です。また、実施状況や改善結果を定期的に経営層・関係部門に報告し、形だけの会議体やルールにならないよう継続的な管理と見直しを行いましょう。

AIモデルの可視化と品質評価の仕組みの導入

<課題6>

AIモデルの可視化が難しく、ブラックボックス化しやすく、判断根拠やリスクが把握しづらいことを背景として、技術的な仕組みが現場担当者に十分理解されておらず、具体的な対策内容・手順の明確化や実行に結びつかないケースがあります。

<対策6>

対策として、AI診断・モニタリング・品質評価等の仕組みを導入することを検討してみましょう。

まず、AIの動作および判断根拠を後から客観的に検証できるようにするため、AIの出力に関連するリスクを現象面からチェックする仕組みを導入することが挙げられます。具体的には、新たなリスクや既存のリスクに対応するため、AIの出力やシステムの挙動について定期的にテストケースを自動実行して問題を検出する仕組みや、運用時に確認すべき項目をリスト化して漏れなくチェックできる仕組みを導入し、品質や安全性を多面的に継続監視・改善できる体制を整備します。

また、利用目的や現場の実態に応じて、評価基準やリスク確認項目を柔軟に設定できる仕組みを整備し、多様な観点からAIシステムの技術的な状態を把握することも重要です。そして、モデルやシステムを改修・更新した際には、その後の品質の変化を記録・分析し、継続的に技術的な改善サイクルを推進します。

さらに、仕組みの導入をリードするための専門性を持つ人材を育成することや、外部人材を採用することを検討しても良いでしょう。AIそのものの理解とリスク管理スキルを兼ね備えた人材が運用・改善をリードすることが求められます。具体的には、AI開発者向けに、AI開発スキルだけでなく、リスク管理や法律知識を兼ね備えた人材育成を明確なカリキュラムで推進したり、AIリスク管理の実務経験を積める環境を用意し、複数の部門を横断してノウハウを広めるリーダー育成・ジョブローテーションを実施したりすることが有効です。また、AI分野やリスク管理領域で実績のある専門人材を外部から採用することも選択肢の一つです。

技術・リスク動向への継続的なキャッチアップ体制の構築

<課題7>

日々新たなAIモデルやサービスが提供・アップデートされるため、リスクや技術動向に対するキャッチアップが追いつかず、適切な評価や対策立案が困難となっているケースがあります。

<対策7>

対策として、新たな技術・リスク動向への継続的なキャッチアップ体制を整備しましょう。

具体的には、国内外のAI技術やリスク、法規制の最新動向について、AIガバナンス推進部門やIT・デジタル部門のみならず法務部や広報、リスク管理部門などの関係部門と連携して情報を収集・分析し、定期的に社内で共有する仕組みを整備することが重要です。また、収集した知見をもとに、必要に応じて運用手順や評価基準の見直しを行うことも欠かせません。

法務部や広報等の関係部門も巻き込み、定期的な情報収集・共有を行うフローを設置することで、多部門連携による技術・リスク動向のモニタリングが可能になります。さらに、各部門の知見を活かし、運用手順や評価基準の継続的な見直しを行う社内共有とフィードバックの仕組みを構築することで、変化の激しいAI技術に対応できる体制を整えることができます。

4.まとめ

AIガバナンスの構築では、計画段階で必要な準備を整えた上で実際の運用を開始し、運用によって得られた知見を活かして継続的に改善を重ねる柔軟な姿勢が重要です。

AIを取り巻くリスクや技術は常に変化し続けるため、うまくいかないことや新たな課題が出てくるのは当然です。こうした状況に俊敏に対応し続けるためには、まず自社が現在直面している課題と、その課題が発生している段階を正確に見極めることが不可欠です。その上で、必要な対策を選択して実施し、継続的に改善していくことが、実効性のあるAIガバナンスの実現につながります。

また、AIガバナンスは現場レベルの検討だけにとどめず、経営層が積極的に関与し、全社的な意思決定のスピードを高めることで、企業の競争力向上につなげることが大切です。

さらに、必要な人材やノウハウが社内に十分にない場合や、より迅速にガバナンスを強化したい場合は、専門家や外部の知見を効果的に活用することも有効な選択肢となります。

変化の激しいAI時代においては、「まず動く」「継続的に磨き上げる」「経営層のリーダーシップ」「外部知見も柔軟に取り入れる」といった実践的なアプローチが、AI時代のガバナンス強化のカギとなるでしょう。

プロフィール

-

笹治 誠

ITマネジメントコンサルティング部

日系製造業の海外事業統括部門にてDX推進、ITガバナンス構築推進などに従事。2023年に野村総合研究所に入社以降、グローバルITガバナンス構築推進やDX推進、AI利活用推進、AIガバナンス構築推進業務等に従事。専門分野は、DX推進支援、グループITマネジメント改革、AIマネジメント。

※組織名、職名は現在と異なる場合があります。